Per la community Drupal, gennaio è il mese in cui si spengono le candeline: oggi, il 15 gennaio 2026, festeggiamo 25 anni di una tecnologia che ha plasmato il web. 🎂

Ma nell'Open Source, il modo migliore per onorare un progetto è costruirne il futuro e raccontarlo. Quale momento migliore, quindi, per fermarsi, mettere ordine e condividere le nostre contribuzioni all'ecosistema?

Il 2025 è stato l’anno in cui l’intelligenza artificiale è passata da “feature interessante” a infrastruttura. Un po’ come il cloud un decennio fa: prima curiosità, poi sperimentazione, infine inevitabilità. In mezzo, una domanda che chi lavora su piattaforme digitali non può più rimandare: “Come portiamo l’AI in produzione… senza perdere controllo, sicurezza e qualità?”.

È esattamente qui che si inserisce la Drupal AI Initiative: un progetto nato per trasformare l’energia (molto reale) della community in una visione coordinata, con l’obiettivo di rendere Drupal non solo “compatibile con l’AI”, ma CMS enterprise-grade anche quando l’AI entra nel cuore dei flussi editoriali e di business.

In SparkFabrik non siamo rimasti a guardare, abbiamo capito che non volevamo essere semplici utilizzatori di questa nuova tecnologia, ma dei “makers”. D’altronde, l'Open Source non è una "strategia di marketing" per noi, è parte della nostra storia e del nostro DNA.

Abbiamo scelto di esserci, con contribuzioni concrete, su aree che abbiamo identificato come decisive per l’adozione reale: developer experience, governance & sicurezza (guardrails), RAG & search, agentic workflows (MCP e toolchain), integrazioni enterprise e, cosa spesso sottovalutata, comunicazione e community building.

Ecco come abbiamo contribuito a costruire il futuro di Drupal nel 2025 (spiegato con un taglio tecnico, ma pensato anche per chi deve prendere decisioni).

E a proposito di contribuzione: quale occasione migliore per annunciare che sabato 31 gennaio ospiteremo il Drupal Contribution Day a Milano? È ormai un appuntamento ricorrente e irrinunciabile nei nostri uffici, un momento per incontrarsi, scrivere codice insieme (ma non solo!) e "restituire" alla community. Registrati qui per partecipare assieme a noi!

Cos’è la Drupal AI Initiative

La Drupal AI Initiative è un progetto strategico che ha l'obiettivo di integrare l’AI in Drupal in modo efficace, evolvendo il sistema per posizionarlo come il miglior “CMS agentico” open-source.

L’ecosistema Drupal parlava già AI da tempo, con funzionalità, integrazioni e moduli che crescevano e fornivano un assaggio di ciò che era possibile. Tuttavia, si è capito che per portare un impatto strategico reale era necessario andare oltre le contribuzioni frammentate, incanalando gli sforzi.

Con questa consapevolezza, il 9 giugno 2025 è stata lanciata la Drupal AI Initiative, con l'obiettivo di portare struttura, strategia e direzione condivisa all’innovazione (ed una visione comune di AI a supporto delle persone, sicura e pienamente governabile anche in ambienti enterprise). In altre parole: non solo “moduli AI”, ma una direzione comune, un framework e un ecosistema capace di crescere senza perdere governabilità.

Per chi prende decisioni (CTO, CDO, responsabili digital, marketing lead) questo punto è enorme: significa poter portare AI nelle esperienze digitali senza lock-in su un provider, senza dover ricostruire tutto da zero, e con l’ossatura di governance tipica di Drupal.

Prima di tutto: chi ha contribuito (persone, non solo codice)

L'innovazione è guidata dalle persone. La nostra contribuzione non sarebbe stata possibile senza un investimento strutturale importante: da giugno 2025, abbiamo dedicato il 50% del tempo lavorativo di due dei nostri migliori talenti tecnici esclusivamente alla Drupal AI Initiative.

Non parliamo di ritagli di tempo, ma di un impegno costante, quotidiano. Una quantità di risorse giustificata dalla visione strategica interna, e spesso alimentata ulteriormente da una passione personale che va ben oltre l'orario d'ufficio.

|

Contributor |

Ruolo & Focus |

|

Lead Developer & Architect. Drupal contributor e speaker, con esperienza su moduli e integrazioni avanzate (tra cui WebProfiler, Monolog, Symfony Messenger, Search API Typesense) Ha lavorato sulle fondamenta infrastrutturali (Runner, Guardrails) e sulle architetture complesse (ambiente di sviluppo DDEV). |

|

|

Senior Developer & Maintainer. Contributor su diversi moduli e integrazioni (Iubenda, Search API Typesense, Panther, TMGMT Lara Translate, MCP Client). Si è concentrato sull'interoperabilità (MCP), RAG e integrazioni verticali. |

L’esperienza pregressa del team è stata fondamentale, perché molte delle nostre contribuzioni 2025 non sono state esercizi teorici, besì scelte tecniche fatte da chi ha già visto cosa funziona (e cosa si rompe) quando un progetto deve vivere nel mondo reale.

Come abbiamo lavorato: governance, ritmo e allineamento

A guidare la visione strategica è stato il nostro CTO, Paolo Mainardi, che ha coordinato le attività con metodo preciso per assicurare di produrre valore in modo continuativo (e non solo per l’ecosistema e la community, ma anche per affrontare le veresfide enterprise dei nostri clienti).

Nel 2025 abbiamo lavorato per sprint, con issue e milestone dedicate, allineandoci con weekly calls interne di coordinamento. Inoltre, abbiamo sempre partecipato agli allineamenti settimanali asincroni della community per portare la nostra prospettiva. Questo modello ci ha permesso di:

- scegliere priorità e “tagliare” ciò che non portava valore

- esplorare e approfondire diverse soluzioni, oltre alle contribuzioni

- definire e far evolvere i PoC in soluzioni riusabili

- mantenere un flusso costante di contribuzioni, nonostante la pressione dei progetti commerciali

- creare un ponte stabile tra lavoro tecnico e comunicazione.

In merito all’ultimo punto, infatti, un aspetto importante è stato il lavoro insieme al team marketing: Stefano Mainardi (CEO) e Alessandro De Vecchi hanno lavorato costantemente per raccontare Drupal, l’AI Initiative, e ciò che stavamo costruendo.

Perché l’open source funziona davvero quando si costruisce e si condivide.

Ambiente di sviluppo AI in Drupal: il nostro add-on DDEV per abbassare la barriera all’ingresso (DDEV development environment)

La prima grande sfida che abbiamo affrontato è stata infrastrutturale. A giugno, all’inizio della Drupal AI Initiative, contribuire allo sviluppo era complesso e rallentato da un fondamentale collo di bottiglia in termini di Developer Experience (DevEx).

La nostra prima grande contribuzione è stata quindi un ambiente di sviluppo basato su DDEV, pensato per rendere replicabile e veloce il setup locale, e per permettere di lavorare su più moduli contemporaneamente senza impazzire.

Più nel dettaglio, il problema principale era la complessità nel configurare un ambiente di sviluppo locale per lavorare efficacemente in un contesto come quello di Drupal AI, in cui occorre lavorare e testare simultaneamente più moduli. La gestione delle dipendenze era decisamente poco flessibile (con il rischio di doverle reinstallare ogni volta), solo un progetto per volta poteva essere clonato (rendendo necessari tanti git clone manuali quando si doveva lavorare su più moduli) e la necessità di dover aggiungere (e mantenere) alcuni file di configurazione specifici di DDEV rendevano tutto tedioso e poco scalabile.

Il nostro impegno si è rivolto quindi ad abbassare queste barriere all’ingresso e accelerare il ciclo di innovazione per l’intera community, fornendo agli sviluppatori un ambiente locale di sviluppo AI pre-configurato e funzionante in brevissimo tempo.

La nostra strategia si è evoluta in due fasi, con una soluzione generale ed una specializzata. Il primo passo è stata la proposta di un nuovo add-on DDEV (DDEV Drupal Suite add-on), uno strumento generico che può essere usato da qualunque modulo contrib, semplifica drasticamente il setup e rende snella la contribuzione a più moduli contemporaneamente.

Sulla base di questo, abbiamo sviluppato prima una “Drupal recipe” (AI Dev Recipe) che installa e configura un set minimo di moduli AI, quindi anche un wizard interattivo via CLI (DDEV Drupal AI Add-on) che orchestra l’intera configurazione delle funzionalità AI, gestisce automaticamente dipendenze, config e install, e risulta anche facilmente estensibile con semplici istruzioni YAML.

Inoltre, lo sviluppo è continuato per rendere la soluzione ancora più flessibile, ad esempio includendo il supporto per database vettoriali pronti all’uso (PostreSQL, pgvector), ma anche il supporto opzionale per scenari ad alte prestazioni (Milvus) e per strumenti di quality assurance (GrumPHP).

Oggi, questa soluzione è utilizzata dalla community globale ed è rintracciabile come add-on. In parallelo, per agevolare ulteriormente l’adozione, abbiamo anche proposto di trasferirla nel namespace ufficiale di DDEV, così da renderla lo standard assoluto per lo sviluppo AI in Drupal. È stato uno dei nostri primi contributi, ma ha gettato le basi per tutto il resto.

Perché questa contribuzione conta anche per il business? Perché quando l’AI entra in un CMS enterprise, l’impatto è tanto funzionale quanto organizzativo. La velocità con cui un team può fare test, fix, iterazioni e release determina il vero time-to-market. E un ambiente di sviluppo standardizzato è spesso un primo, potente moltiplicatore di produttività.

Guardrails: portare sicurezza, governance e controllo nell’AI di Drupal

Ogni volta che parliamo di AI in produzione, prima o poi arriviamo qui: fiducia.

L’AI può creare contenuti, riassumere, classificare, orchestrare azioni, chiamare tool esterni. Ma può anche “allucinare” (con grande sicurezza), deviare da policy aziendali, esporre dati sensibili, generare output non sicuri o non appropriati.

Pensa ad esempio: come possiamo garantire che un chatbot non fornisca risposte inappropriate, suggerendo il prodotto di un competitor, offendendo l’utente o inventando informazioni false? E come possiamo impedire che dati sensibili (PII) vengano inviati a provider terzi (tramite i nostri prompt, oppure tramite informazioni raccolte da agenti autonomi)?

I rischi sono reali e, nel mondo enterprise, un'AI che "allucina" o che risponde in modo inappropriato non è solo un bug, è un rischio reputazionale inaccettabile. E se condivide dati sensibili, è una violazione ancora più grave. Mentre molti si concentravano sulla generazione di testo, noi ci siamo concentrati sul controllo.

Per questo, abbiamo lavorato nella definizione dei cosiddetti “Guardrails”, delle regole intelligenti che controllano e guidano il comportamento dell’AI, effettivamente limitandola per far si che rispetti indicazioni, valori ed obiettivi di ciascuna realtà.

Nella nostra visione, i guardrails non sono opzionali: sono un requisito strategico per rendere l’AI deployable in contesti reali.

Definizione dei guardrails in Drupal AI

La contribuzione di Luca su questo fronte è stata sostanziale, a partire dalla definizione stessa del concetto di Guardrails in Drupal (che ha rivelato un’ampiezza molto maggiore di quanto inizialmente ipotizzato).

- I guardrails sono infatti necessari come layer trasversale per tutte le interazioni con gli LLM: moduli, agenti, chatbots, generatori di contenuti, ecc. Importante, i guardrail sono essenziali anche per rendere sicure le comunicazioni con altri sistemi esterni, proteggendo lo scambio di parametri e dati sensibili, come quelli gestiti tramite MCP.

- Devono analizzare sia l’input dell’utente e sanitizzare i dati prima che arrivino all’LLM (es. rimuovendo dati personali o bloccando topic vietati), sia l’output dell’AI, analizzando la risposta prima che venga mostrata all’utente.

- In caso di check fallito un guardrail può bloccare completamente l’esecuzione di una richiesta (“Scusa, non posso rispondere per violazione delle policy”) o riscrivere input/output rimuovendo i dati problematici (“Ecco la risposta omettendo le informazioni personali”).

- Un singolo filtro non è tipicamente sufficiente. Serve piuttosto un “Set di Guardrails” che operano in contemporanea, ognuno specializzato su diversi tipi di controlli (es. uno dedicato alle informazioni personali, uno ai contenuti vietati, uno dedicato ai permessi utente).

La nostra contribuzione è culminata con la creazione di una nuova architettura a plugin per gestire i guardrails. La soluzione è altamente personalizzabile: non solo supporta la configurazione dei singoli guardrails, ma anche la possibilità di combinare più controlli in diversi set.

Sono supportati sia controlli sugli input degli utenti (controlli “pre-LLM”), sia sull’output dell’AI (controlli “post-LLM”), ed è possibile definire check diversi nelle due fasi, per esigenze differenti. Non da ultimo, sono implementati guardrails di due tipologie distinte: di tipo deterministico (regex) e di tipo non deterministico (LLM-based topic detection).

Per i decision-maker, il valore di questo contributo è immenso: i guardrail trasformano Drupal AI da un promettente esperimento tecnologico a una piattaforma affidabile, sicura e pronta per l'impresa, in cui l'AI lavora sempre per il business, e mai contro di esso.

Supporto per Bedrock e sovranità dei dati

Durante gli esperimenti abbiamo esplorato le principali soluzioni di Guardrails già presenti, con un particolare focus su AWS Bedrock, una delle soluzioni più potenti sul mercato.

I nostri testi hanno confermato l’ottima compatibilità con moltissime lingue (compreso l’italiano), in particolare delle funzioni di PII masking, guardrails specifici per la rimozione di informazioni personali senza bloccare l’esecuzione.

Ma è importante raccontare la realtà con onestà: un servizio esterno (extra-europeo) introduce implicazioni di privacy, interrogativi di compliance e dipendenza tecnologica (vendor lock-in).

Tali preoccupazioni sono particolarmente rilevanti in contesti regolamentati (o nella PA), in cui va valutato seriamente quali dati sono trasmessi all’esterno, come vengono trattati, quale rischio residuo resta.

Per questo, pur supportando Bedrock, la nostra architettura è pensata per essere agnostica. Permette di integrare in futuro altre soluzioni (come Azure, Google Cloud, Guardrails.ai) e, alternativa molto interessante, anche modelli locali, per garantire la sovranità dei dati.

Streaming, guardrails, evoluzioni

Un altro punto tecnico che abbiamo affrontato è la complessità dei guardrails in presenza di risposte in streaming, ovvero quando l’AI invia ogni pezzo della risposta man mano che la genera, e non solo l’output completo alla fine della generazione.

Per l’esperienza utente, lo streaming è una feature decisamente apprezzata. Tuttavia, in presenza di streaming non è sufficiente eseguire un check finale dell’output, perchè l’utente potrebbe già essere stato esposto a informazioni non idonee. Piuttosto, il controllo dei guardrails va effettuato ad ogni aggiornamento della risposta da parte dell’LLM (ad ogni nuovo token di output).

Validare output token-by-token, gestire tool call nel flusso e contemporaneamente attivare set di guardrails ad ogni aggiornamento è un tema non banale.

La soluzione temporanea è stata disabilitare lo streaming quando i guardrails sono attivi, in attesa di un approccio più robusto. È un dettaglio importante per l’usabilità, passando da soluzione “sicura” a “sicura e piacevole da usare”.

E c’è un altro fronte che nel 2026 dovrà essere affrontato: guardrails per contenuti multimediali (immagini, video). È un tema ancora da approfondire, ma sappiamo già che non potrà essere lasciato alla buona.

AI Agents in produzione: task asincroni e streaming con Symfony Messenger (per superare i limiti di PHP)

Gli Agenti AI sono tutt’altra entità rispetto ai semplici chatbot di una volta. Un agente complesso pianifica, esegue step multipli, chiama tool, gestisce errori, interroga database, elabora dati. Insomma, gli Agenti richiedono tempo per “ragionare”, con processi che possono durare anche diversi minuti.

Ed è qui che il classico modello sincrono di una web request PHP mostra i suoi limiti: timeout, sessioni che si chiudono, UI che interrompe l’esecuzione, difficoltà di retry/monitoraggio.

Il problema è quindi: come facciamo girare agenti complessi su un sito Drupal, senza che la pagina vada in timeout? Un problema reale, emerso anche su un progetto per un nostro cliente.

Per rispondere a questo limite, abbiamo sviluppato una soluzione ed un PoC di “AI Agent Runner” basato su Symfony Messenger, con due obiettivi chiari:

- esecuzione asincrona di task agentici (robusta, retryable, monitorabile), disaccoppiando l’esecuzione dell’agente dalla richiesta web dell’utente.

- streaming delle risposte verso il frontend quando serve un’esperienza conversazionale fluida, continuando a supportare l’esecuzione sincrona con (quasi) lo stesso codice.

Questa contribuzione è stata anche portata in un contesto pubblico: un webinar tecnico organizzato insieme al team che coordina la Drupal AI Initiative, in cui Luca ha mostrato come Symfony Messenger possa diventare un pezzo chiave per superare i limiti architetturali di Drupal e PHP quando si parla di agenti.

Per un decision maker, il punto è molto semplice: con la sola esecuzione sincrona, gli agenti restano prototipi belli ma limitati e fragili. Con un’architettura asincrona, l’automazione può diventare complessa e affidabile.

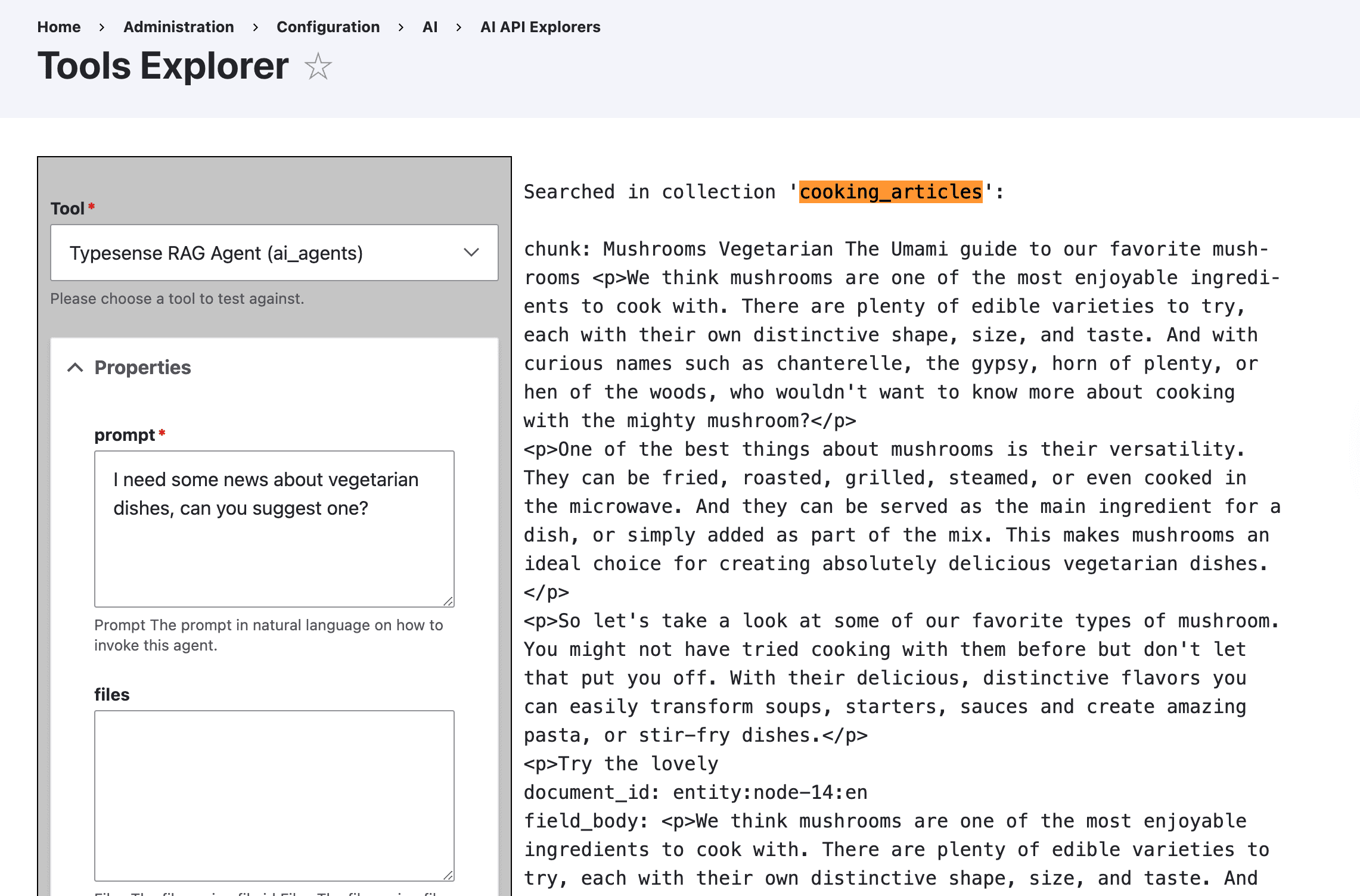

RAG e Typesense

Uno dei modi più rapidi per perdere fiducia nell’AI è chiederle qualcosa che dovrebbe sapere… e vedere una risposta plausibile ma sbagliata. La RAG (Retrieval-Augmented Generation) nasce per questo: ancorare le risposte a una base di conoscenza reale e controllabile.

SparkFabrik è storicamente maintainer del modulo Search API Typesense, cosa che ci ha conferito esperienza profonda sia sulla ricerca “classica”, sia sull’evoluzione verso la ricerca semantica e i database vettoriali. Con l'avvento dell'AI, era naturale per noi evolvere questo strumento.

Roberto Peruzzo ha lavorato sull’implementazione del supporto Typesense per la RAG nel modulo AI, con un approccio che punta a migliorare pertinenza ed efficienza.

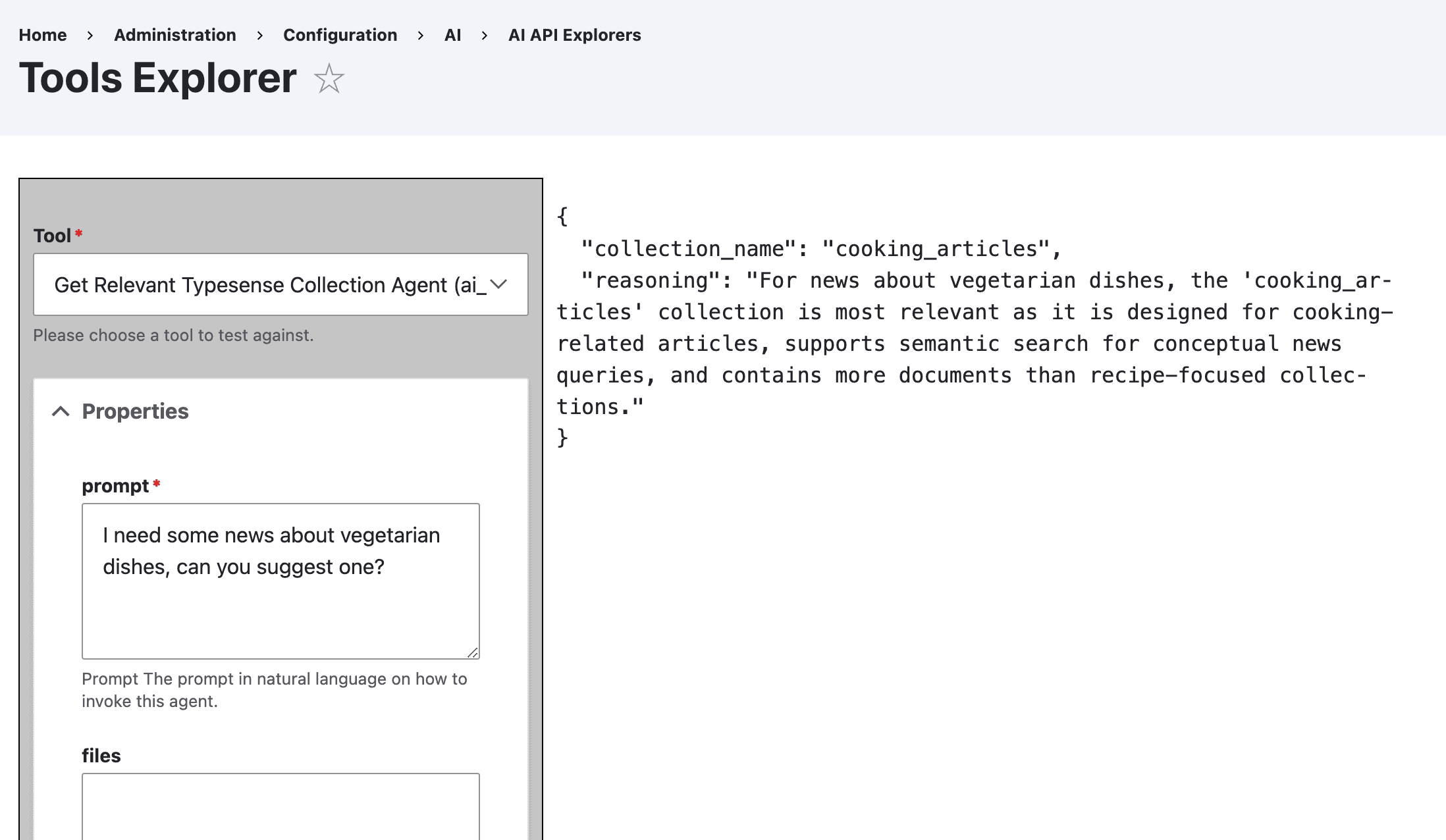

Uno degli elementi più interessanti che abbiamo introdotto è il concetto di "Router Agent", un sub-agent che determina “dove cercare”. In un sistema complesso con molti indici (es. Manuali Tecnici, Blog, Prodotti), interrogare tutto è inefficiente. Dato un input dell’utente, l’agente principale attiva il sub-agent per selezionare la collezione più pertinente da interrogare su Typesense (in base all’intento), prima di formulare la risposta finale.

Questo riduce il "rumore" (dati irrilevanti inviati all'AI) e le allucinazioni, abbassa i costi dei token e aumenta drasticamente la precisione delle risposte. In più, il routing dinamico evita di dover hardcodare la mappatura delle collezioni ed aggiungere nuove collections non richiede nuovo codice.

Insomma, si ottiene un'esperienza utente migliore, codice scalabile ed un risparmio economico.

MCP: Drupal che diventa contesto e toolchain per gli agenti

MCP (Model Context Protocol) è uno dei “pezzi” che rendono Drupal dialogante con sistemi, strumenti e agenti esterni in modo standardizzato. È una delle prossime grandi frontiere, e nel 2025 abbiamo lavorato e contribuito su MCP in più fasi.

Esplorazione e direzione

Siamo partiti con un’esplorazione dello stato dell’ecosistema Drupal MCP: capire cosa era già possibile fare, cosa mancava e dove avesse senso investire per generare valore anche per i nostri progetti reali. In questa fase abbiamo anche ipotizzato l’uso di JsonAPI tramite MCP per costruire frontend disaccoppiati.

PoC: generare un frontend React via JSONAPI + Tools

Dopo l’esplorazione, abbiamo realizzato un esperimento più concreto con l’obiettivo di testare l’efficacia dell’approccio ed il potenziale del protocollo: creare un’app React completa tramite un AI connessa al server MCP di Drupal, in grado di leggerne struttura e contenuti (content types, campi…).

Realizzato tramite un prompt molto dettagliato e suddiviso in diverse fasi (“spec-driven development”), l’esperimento è stato un successo: ha dimostrato che Drupal può esporre la sua struttura ("intelligenza") a sistemi esterni, permettendo all'AI di agire non solo come generatore di testo, ma come sviluppatore junior guidato dal contesto del CMS (e supervisionato).

Brainstorming su use case concreti e lavoro in corso

Successivamente abbiamo fatto un brainstorming interno per definire use case solidi e ripetibili, per stakeholder diversi. Ne sono emersi due:

- per Drupal developer: partire da un modello SDC e generare entità, paragrafi e campi via MCP

- per frontend developer/site builder: costruire un frontend disaccoppiato usando solo il server MCP

Abbiamo scelto di approfondire il primo use case, oggi ancora in corso con l’esplorazione sull’automazione della generazione della struttura backend a partire da template SDC.

Migliorare MCP in Drupal e diventare maintainer

Parallelamente, abbiamo anche contribuito direttamente al miglioramento dell’implementazione di MCP in Drupal.

Roberto è diventato maintainer del modulo Drupal MCP Client, modernizzandolo per supportare la nuova Tool API e migliorando la sicurezza con il supporto per gli header di autenticazione (come bearer token). Non da ultimo, Roberto ha contribuito anche con bugfix al modulo Drupal MCP per rendere Drupal un server MCP.

Perché MCP conta anche per chi guarda al business? Perché è una tecnologia “abilitante”. È ciò che permette agli agenti di non essere solo interfacce conversazionali, ma operatori che sanno usare strumenti, interagire con API, eseguire azioni e automatizzare processi.

Integrazione Lara Translate: traduzioni AI enterprise, multi-lingua di qualità

La traduzione è uno dei casi d’uso più immediati e concreti dell’AI nei sistemi di contenuto enterprise: siti multi-country, cataloghi, knowledge base, documentazione, compliance.

Parallelamente ai lavori infrastrutturali, SparkFabrik ha risposto ad un’esigenza cliente specifica sviluppando il modulo TMGMT Lara Translate. Lara è un modello AI specializzato nei task di traduzione, con output qualitativamente superiori agli LLM generalisti (ChatGPT, Gemini, Llama…) e mantenendo coerenza lessicale e stilistica.

Il modulo integra Lara come translation provider all'interno del sistema TMGMT (Translation Management Tool) di Drupal, supportando tutte le features uniche di Lara e con attenzione anche a dettagli pratici come lo splitting efficace del testo e logiche di gestione degli errori.

Un aspetto interessante è che questa contribuzione ha anche innescato un contatto diretto, aprendo opportunità di collaborazione e dimostrando come le esigenze di progetto possano trasformarsi in contribuzioni di valore per la community.

Oltre il codice: divulgazione e community

Contribuire non significa solo scrivere codice. Significa anche raccontare: spiegare cosa stiamo facendo, cosa è pronto, cosa è in evoluzione, e soprattutto perché vale la pena investire. Nel 2025, siamo davvero fieri del lavoro corale tra team tecnico e marketing per tradurre il nostro lavoro in cultura condivisa.

Content: Drupal AI Logs e articoli blog

Abbiamo raccontato alcune delle contribuzioni anche sui nostri canali social tramite la serie Drupal AI Logs, rendendo trasparente il processo contribuzione, trasformando update tecnici in insight fruibili e (speriamo) ispirando altri contributors e teams a sperimentare.

Un grande effort è stato dedicato anche nella produzione di articoli blog dedicati a Drupal e Drupal AI (anche nel tech blog), condividendo le nostre prospettive e promuovendo l’ecosistema del nostro CMS preferito (nel solo 2025 abbiamo condiviso ben 13 articoli verticali su Drupal).

DrupalCamp Italy 2025: due talk, due prospettive complementari

A novembre 2025, non abbiamo solo contribuito all'organizzazione di DrupalCamp Italy. Abbiamo anche portato la Drupal AI Initiative sul palco, con due talk che, insieme, raccontano bene il nostro approccio.

- Lo stato della Drupal AI Initiative.

Luca Lusso ha condiviso lo stato complessivo dell’iniziativa ed alcune nostre contribuzioni, offrendo una visione da insider, realistica e priva di hype. L’obiettivo: ispirare la community italiana e promuovere l’iniziativa. (Registrazione del talk e slides). - Agenti AI in Drupal e MCP (con PoC)

Roberto ha mostrato come implementare agenti AI in Drupal, sia via UI sia via codice. Nel talk ha mostrato un PoC di AI Customer Assistant per e-commerce: un agente che conversa con l’utente, cerca prodotti, suggerisce opzioni, aggiunge al carrello e notifica eventi in Slack tramite MCP. (Registrazione del talk e slides).

Webinar tecnico: AI Agents on Symfony Messenger per agenti AI “robusti”

Come accennato sopra, abbiamo contribuito anche a un webinar tecnico internazionale, organizzato con il team che sta coordinando la Drupal AI Initiative (James Abrahams e Marcus Johansson).

Luca ha mostrato il suo PoC basato su Symfony Messenger, mostrando agenti in grado di eseguire task asincroni e di supportare lo streaming dei messaggi (anche in caso di invocazione di tools).

L’obiettivo era mostrare come SM possa diventare un pezzo chiave per superare i limiti architetturali di Drupal e PHP quando si parla di agenti. Interessante, nello stesso webinar è stata condivisa una seconda demo incentrata su FlowDrop e sono intervenuti altri esponenti della community per partecipare alla discussione.

Un extra che nasce dall’iniziativa: workshop su GitHub Copilot

Nel percorso di studio e R&D legato alla Drupal AI Initiative, abbiamo anche investito nella formazione e condivisione su strumenti di sviluppo AI, come GitHub Copilot.

Abbiamo condiviso la nostra esperienza in un workshop tecnico e pratico tenuto da Luca Lusso, per spiegare nella pratica come integrare Copilot come partner nel ciclo di sviluppo in VS Code.

Il workshop Copilot è gratuito e liberamente accessibile, non verticale su Drupal ma volutamente più aperto al mondo dello sviluppo.

Un anno di innovazione e prospettive future

Il 2025 si è chiuso con un bilancio estremamente positivo per l’ecosistema Drupal, un anno di costruzione in cui SparkFabrik ha contribuito a posare i mattoni fondamentali: un ambiente di sviluppo solido, un framework di sicurezza (Guardrails), un motore di esecuzione robusto (Async Runner su Symfony Messenger) e protocolli di interoperabilità (MCP).

Sotto la guida del nostro CTO Paolo Mainardi, le nostre contribuzioni si sono concentrate su ambiti a grande valore aggiunto e su nodi critici da sciogliere per portare l’AI in progetti reali dei clienti, con forte accento su governance e sicurezza, agenti AI autonomi in grado di compiere azioni complesse (da site building a configurazione).

Abbiamo anche riconosciuto (e promosso) la necessità di supportare stack completamente open source e locali (agnosticismo tecnologico), anticipando le esigenze di sovranità digitale e privacy dei dati richieste dai clienti enterprise europei, soggetti a normative come GDPR, AI Act e Cyber Resilience Act).

|

Riepilogo delle principali contribuzioni tecniche 2025 (Drupal AI) |

||

|---|---|---|

|

Area |

Contribuzione Principale |

Impatto / Risultato |

|

Infrastruttura |

Ambiente di sviluppo unificato DDEV |

Standardizzazione del setup per tutti i contributori globali. |

|

Sicurezza |

Guardrail Agents Architecture |

Framework per la sicurezza degli input/output AI, visualizzabile e configurabile. |

|

Performance |

AI Agents su Symfony Messenger: Async Runner & Streaming |

Esecuzione di agenti complessi senza timeout, esecuzione sincrona e asincrona, UX reattiva grazie allo streaming in tempo reale. |

|

Ricerca |

RAG e Router Agent |

Sistema intelligente per indirizzare le query all'indice corretto, riducendo costi e rumore. |

|

Interoperabilità |

Drupal MCP Server & Client |

POC per la generazione di frontend React da Drupal via AI con MCP; modernizzazione del client MCP. |

|

Localizzazione |

TMGMT Lara Translate Provider |

Integrazione di servizio di traduzione professionale nel flusso editoriale Drupal. |

Guardando al 2026, la nostra visione è chiara. Drupal non è più "solo un CMS". Si sta posizionando come la piattaforma ideale per l'Enterprise AI: un luogo dove i dati sono strutturati, sicuri e accessibili, e dove l'intelligenza artificiale non è un giocattolo solo per “effetto wow”, ma uno strumento governato da regole precise di compliance e sicurezza. È esattamente il tipo di AI che serve per la produzione, non per le demo.

SparkFabrik continuerà a essere in prima linea. Non ci limiteremo a usare l'AI; continueremo a scrivere il codice che la rende possibile, aperta e sicura per tutti, per progetti reali.

In SparkFabrik, combiniamo una profonda expertise tecnica su Drupal con competenze avanzate in AI integration, architetture composable e governance enterprise. I nostri servizi di sviluppo Drupal coprono l'intero spettro: da consulenza strategica sull'AI readiness della tua architettura attuale, a implementazione di soluzioni AI-powered custom, fino a sicurezza, supporto continuativo e ottimizzazione.

Se stai valutando come integrare AI in Drupal (o in un ecosistema enterprise più ampio), e vuoi farlo con un partner che ci ha messo le mani davvero (a livello di prodotto, di community e di delivery) parliamone.

Questo articolo è parte della nostra serie dedicata a Drupal. Per esplorare altri aspetti della piattaforma, vi invitiamo a consultare i nostri precedenti articoli su caratteristiche e vantaggi, confronto con le alternative, strategie di migrazione, sicurezza e compliance, architettura composable, Design System, Drupal headless omnicanale e panoramica e novità di Drupal AI.

- Post precedente

- Vedi tutti i post

- Post successivo